The Deepfakes and the spread of false news

Autores: MSc. Yolagny Díaz Bermúdez / yolagny.diaz@mtz.jovenclub.cu

Lic. Melba Luisa González Camejo

La frase “Una mentira repetida mil veces puede convertirse en verdad”, del ministro nazi Paul Joseph Goebbels (según la historia), ha sido una práctica seguida por muchos desde los inicios del desarrollo social de la humanidad. Resultan incontables las veces que el ser humano ha estado expuesto a la difusión de alguna que otra mentira o noticia falsa creada para conseguir un objetivo determinado.

De la situación anterior muchos no se preocupan pues tienen la certeza de que “la verdad siempre sale a la luz” o “la mentira tiene patas cortas”. Sin embargo nos encontramos en un punto en el que el desarrollo tecnológico anula o limita las posibilidades que tiene la verdad de salir a flote, al menos no en un corto espacio de tiempo.

Las redes sociales se han convertido en el combustible ideal para la propagación de noticias, ciertas o falsas. Resulta un medio en el que nadie, o pocos, cuestionan lo que leen y peor aún, si les resulta interesante o acorde a su ideario, la comparten con sus amigos o seguidores sin dudar.

A todo lo anterior se le suma el surgimiento de montajes de videos muy realistas creados con una tecnología basada en algoritmos de inteligencia artificial que hace natural lo imposible. Videos falsos, que a todas luces, parecen verdaderos, deepfakes (mentiras profundas). Grabaciones en las que una persona hace y dice cosas que nunca hizo ni dijo.

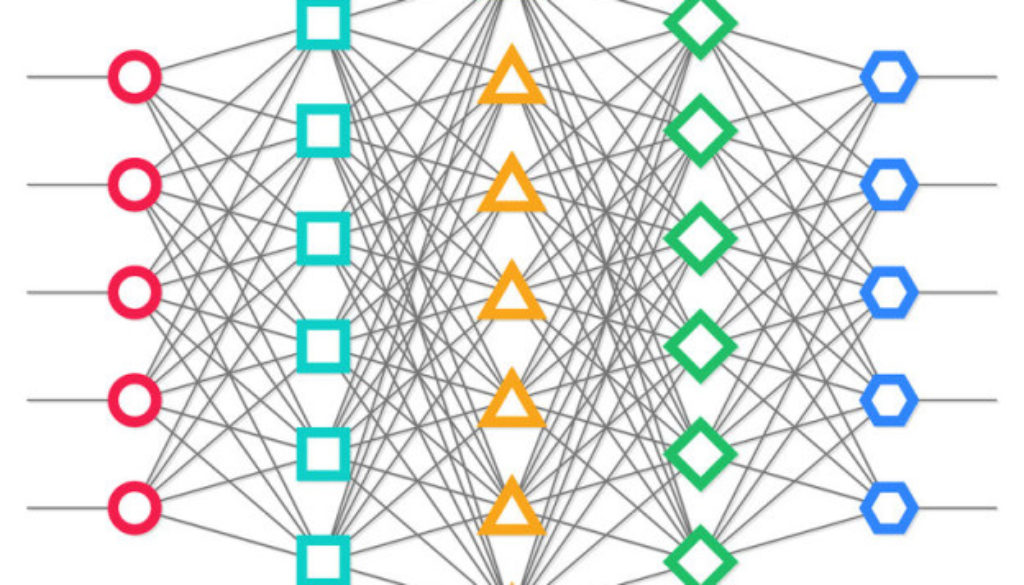

El método de creación se basa en una red generativa adversativa (GAN). Como su nombre indica, en realidad son dos redes neuronales adversarias (dos software) que trabajan juntas para mejorar el resultado. Una red genera las imágenes a partir de una base de datos y la otra, la adversaria, verifica si son reales.

Al trabajar a la vez, estas dos redes producen mejores falsificaciones. Por esta razón para crear las imágenes del video falso necesitan de materia prima horas de videos con calidad, así como múltiples imágenes reales de la persona o estructura objeto de la falsificación.

¿Quién se expone a verse reflejado en un video falso?

La esfera pública, evidentemente, resulta un campo fértil para la falsificación. La tecnología en semejantes términos de manipulación es tentadora para muchos. Orson Welles, hizo creer a todo un país que estaba siendo invadido por los marcianos y rodó al final de su carrera un esclarecedor documental sobre los engaños en el mundo del arte, dijo: «La falsedad es tan antigua como el árbol del Edén». Lo que se puede hacer hoy con el desarrollo tecnológico es un paraíso para los embaucadores.

Se pudiera pensar que sólo los políticos, artistas y personajes públicos se encuentran expuestos a este tipo de peligro, debido a la gran cantidad de imágenes y horas de videos reales que sobre ellos se puede encontrar en Internet, pero no es cierto. Las redes sociales pueden ser el caldo de cultivo que suministre todo el material necesario para este proceso de la mayor parte de las personas que en ellas se encuentran registradas.

Sin ser conscientes de las consecuencias, los usuarios de las diferentes redes sociales ponen en “bandeja de plata” toda la información necesaria para crear una deepfakes sobre su persona.

¿Resultará realmente imposible detectar la veracidad de los Deepfakes?

Precisamente en este procedimiento para crear una deepfakes se encuentra la posible vía para detectar la veracidad o falsedad del video.

Como ya se mencionó, en dicho proceso participan dos redes neuronales, una que genera y la otra que verifica la veracidad. Eso quiere decir que en la misma medida en que se mejora la red neuronal genérica lo hace la red neuronal adversaria, capaz de detectar la falsificación El propio sistema que genera los deepfakes está mejorando a su vez el detector de falsificaciones que a la larga se tendría que usar.

Conclusión

A las puertas de esta realidad se hace necesario detenerse a analizar lo que nos encontramos en nuestro tránsito por Internet, en particular en las redes sociales, donde las noticias se distribuyen como pólvora. Realizamos un llamado a poner en duda lo inverosímil, buscar la forma de verificar lo que leemos antes de dar una noticia por cierta y peor aún difundirla.

Además, ya en el plano personal, tener en cuenta que todo lo personal que se comparte en las redes sociales puede, mañana, ser usado en su contra.

Referencias bibliográficas

Lacort, J. (2018). “Con los deepfakes tendremos un problema con la verdad: ni los vídeos servirán como pruebas.” Recuperado el 2 de enero de 2019, de https://www.xataka.com/robotica-e-ia/deepfakes-tendremos-problema-verdad-videos-serviran-como-pruebas

Pertierra, T. (2018). “Deepfakes», una nueva arma de desinformación masiva.” Recuperado el 2 de enero de 2019, de https://www.diarioinformacion.com/cultura/2018/10/09/deepfakes-nueva-arma-desinformacion-masiva/2071994.html

Taich, D. (2018). “Qué son y cómo combatir Deepfakes.” Recuperado el 2 de enero de 2019, de https://www.cronista.com/columnistas/Que-son-y-como-combatir-deepfakes-20181029-0091.html Zavia, M.S. (2017). “Ver cómo una red neuronal inventa caras fotorrealistas es espeluznante.” Recuperado el 2 de enero de 2019, de https://es.gizmodo.com/ver-como-una-red-neuronal-inventa-caras-fotorrealistas-1819970865